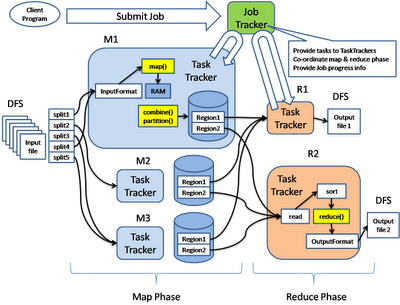

کتاب آموزش آپاچی هادوپ Hadoop به زبان فارسی را نوشته مهندس بیژن محمد پور را برای شما کاربران عزیز سایت آغازه آماده کرده ایم که امید است مورد توجه شما قرار بگیرد. هادوپ یک چهرچوب و فریم ورک نرم افزاری است که به صورت متن باز با زبان جاوا عرضه شده است که امکان پردازش های توزیع شده بر روی داده های بزرگ Big Data را بر روی سرورها میسر می سازد. هادوپ امکان پردازش های توزیع شده را با تحمل پذیری خطای بالا را داراست. از جمله استفاده کنندگان هادوپ شرکت های بزرگی مانند فیس بوک و یاهو می باشند. هسته اصلی هادوپ از یک بخش ذخیرهسازی (سیستم فایل توزیع شده هادوپ یا HDFS) و یک بخش پردازش (Map/Reduce) تشکیل شده است. هادوپ فایلها را به بلوکهای بزرگ شکسته و آنها را بین نودهای یک خوشه توزیع میکند. برای پردازش داده، بخش Map/Reduce بسته کدی را برای نودها ارسال میکند تا پردازش را به صورت موازی انجام دهند. این رویکرد از محلیت داده بهره میبرد (نودها بر روی بخشی از داده کار میکنند که در دسترشان قرار دارد). بدین ترتیب دادهها سریعتر و کاراتر از وقتی که از یک معماری متکی بر ابر-رایانه که از سیستم فایل موازی استفاده کرده و محاسبه و داده را از طریق یک شبکه پر سرعت به هم وصل میکند، پردازش میشوند.

عنوان: آموزش آپاچی هادوپ Hadoop

زبان آموزش : فارسی

نویسنده: بیرژن محمد پور

تعداد صفحه: ۴۵

حجم فایل: ۱٫۵ مگابایت

کلمات کلیدی: آموزش آپاچی هادوپ , معماری هادوپ , نصب و راه اندازی Hadoop , کتاب آموزش هادوپ , آپاچی هادوپ , کتاب آموزش آپاچی هادوپ

تاریخچه هادوپ:

هدوپ توسط Doug Cutting سازنده Apache Lucene که بصورت گسترده برای عمیات جستجوی متن ها استفاده می شود ، تولید شد. در حقیقت به وجود آمدن هدوپ از کار بر روی Nutch شروع شد. Apache Nutch یک فریم ورک متن باز برای ایجاد موتور جستجو است که بصورت گسترده ، عملیات جستجوی متن ها را به روشی که خزیدن یا Crawling نام گرفت انجام می دهد.

در خصوص نامگذاری نام هدوپ(HADOOP) باید گفت که مخفف عبارت خاصی نیست، این نامی است که پسر Doug برروی عروسک فیل خود که زرد رنگ بود گذاشته بود.

برای شروع ، Doug و همکارش Mike ایده ساختن یک موتور جستجوگر وب را در سر داشتند اما این تنها چالش آنها نبود ، قیمت سخت افزار یک موتور جستجوگر که ۱ میلیون صفحه وب را جستجو و ایندکس می کند در حدود ۵۰۰۰۰۰ دلار بود با این وجود آنها باور داشتند که این پروژه یک هدف ارزشمند است.

Nutch در سال ۲۰۰۲ شروع به کار کرد و در همان زمان عملیات و روشهای جستجوی صفحات وب به سرعت رشد کرد. طی زمانی معماران پروژه دریافتند که این پروژه قابلیت و توانایی کار کردن با میلیونها صفحه وب را ندارد ، در همان برهه در سال ۲۰۰۳ مقاله ای از شرکت گوگل منتشر شد که توانست راهگشای مشکل آنها باشد و معماری(Google File system) GFS را توصیف می کرد.

GFS توانست مشکل ذخیره سازی داده های عظیم را حل کند علاوه بر آن مدیریت ذخیره سازی نودها دیگر چالشی بود که در معماریهای قبلی بود و با استفاده از این روش آن مشکل نیز برطرف شد. در سال ۲۰۰۴ تیم Nutch توانست نسخه متن باز خود را با نام Nutch Distributed filesystem (NDFS) منتشر کنند. در سال ۲۰۰۴ گوگل با مقاله ای MapReduce را به جهان معرفی کرد، خیلی زود در سال ۲۰۰۵ برنامه نویسان Nutch شروع به کار با (MR)MapReduce کردند و تا اواسط همان سال Nutch نسخه جدید خود را که با NDFS و MR کار می کرد به جهان معرفی کرد. بعد از چندی معماران Nutch دریافتند که عملکرد آن فراتر از فقط یک موتور جستجوگر است و در فوریه ۲۰۰۶ آنها از پروژه Nutch که خود زیر پروژه Lucine به حساب می آمد به سمت پروژه ای آمدند که آن را Hadoop (هدوپ) نامیدند. در تقریبا همان سال Doug به Yahoo پیوست تا با استفاده از یک تیم مستقل هدوپ را آزمایش و پیاده سازی کند.

در سال ۲۰۰۸ شرکت یاهو ، موتور جستجویی را معرفی کرد که توسط ۱۰۰۰۰ کلاستر هدوپ عملیات جستجو را انجام می داد. در همان سال و در ماه ژانویه هدوپ در بالاترین سطح پروژه های Apache قرار گرفت در آن زمان دیگر تنها Yahoo تنها استفاده کننده این محصول نبود، شرکتهایی نظیر Last.fm ، Facebook و نیویورک تایمز نیز شروع به فعالیت در این حوزه کرده بودند.

در همان سال New York Times تعداد زیادی از روزنامه های خود را که در قسمت آرشیو وجود داشت اسکن کرد که حجم آن نزدیک به ۴ ترابایت داده می شد و سپس با استفاده از پردازش ابری EC2 آمازون و با استفاده از ۱۰۰ ماشین در کمتر از ۲۴ ساعت پردازش خود را به پایان برساند.

در April سال ۲۰۰۸ هدوپ رکورد جهان را شکست و سریعترین سیستمی شد که توانست ۱ ترابایت داده را ظرف ۲۰۲ ثانیه و با استفاده از ۹۱۰ نود کلاستر پردازش کند. این رکورد در سال قبل با ۲۹۷ ثانیه ثبت شده بود. در November همان سال گوگل طی گزارشی اعلام کرد که این رکورد را به ۶۸ ثانیه ارتقاء داده است. در April 2009 یاهو اعلام کرد با استفاده از هدوپ توانسته ۱ ترابایت داده را ظرف ۶۲ ثانیه پردازش کند. و بالاخره در سال ۲۰۱۴ یک تیم از شرکت DataBricks اعلام کرد که توانسته با استفاده از ۲۰۷ نود کلاستر اسپارک حدود ۱۰۰ ترابایت داده را ظرف ۱۴۰۶ ثانیه که تقریبا ۴٫۲۷ ترابایت در دقیقه می شود پردازش کند.

امروزه هدوپ بصورت وسیعی و در زمینه های بسیاری از فعالیتهای دانشگاهی تا تجارت ، از علوم تا نجوم مورد استفاده قرار می گیرد . هدوپ مکانی امن برای ذخیره و تحلیل داده های کلان بشمار می رود ، مقیاس پذیر، توسعه پذیر و متن باز است . هدوپ هدف اصلی کمپانی های بزرگ تولید و ذخیره داده هاست از جمله Facebook ، IBM ، EMC ، Oracle و Microsoft است.

از کمپانیهای متخصص در زمینه سرویس های هدوپ می توان به MapR ، Cloudera و HortonWorks اشاره کرد.

به طور خلاصه ، هدوپ یک فریم ورک یا مجموعه ای از نرم افزارها و کتابخانه هایی است که ساز و کار پردازش حجم عظیمی از داده های توزیع شده را فراهم میکند. در واقع Hadoop را می توان به یک سیستم عامل تشبیه کرد که طراحی شده تا بتواند حجم زیادی از داده ها را بر روی ماشین های مختلف پردازش و مدیریت کند. فریم ورک هدوپ شامل زیر پروژه های مختلفی می شود که در زیر لیست کامل آنها آمده است:

HDFS

YARN

MapReduce

Ambari

Avro

Cassandra

Chukwa

HBase

Hive

Mahout

Pig

Spark

Tez

ZooKeeper

منبع : تاریخچه هادوپ

قابل توجه کاربران شما می توانید این کتاب را یکجا و بطور کامل از لینک زیر دریافت کنید. {plusone}

لینک مستقیم :

![]() برای دریافت فایل اینجا کلیک کنید. (لینک مستقیم)

برای دریافت فایل اینجا کلیک کنید. (لینک مستقیم)

![]() برای دریافت فایل اینجا کلیک کنید. (لینک کمکی)

برای دریافت فایل اینجا کلیک کنید. (لینک کمکی)

بدون دیدگاه